Distribuição

Hadoop

Pacote integrado com

componentes da plataforma Hadoop customizado por várias empresas para atender

as necessidades de diferentes organizações.

Cloudera

Empresa fundada em 2008 por

um grupo de engenheiros da Yahoo, Google e Facebook. É pioneira no

desenvolvimento e distribuição de softwares baseados em Hadoop Apache e é a

fornecedora da CDH (Cloudera Distribution Hadoop).

CDH (plataforma de código

aberto da Cloudera) usa o Hadoop como base e agrega ao projeto original Apache

algumas melhorias. Entre as melhorias podemos destacar o Cloudera Manager que é

um sistema amigável de gestão que apresenta

toda a estrutura do pacote de forma organizada.

A Cloudera é líder de

mercado, fornece uma versão gratuita para download e uma paga e adicionalmente disponibiliza

os serviços de consultoria, suporte, manutenção e treinamento.

Instalação

da versão Cloudera QuickStart VM

Cloudera QuickStart VM => Versão

ideal para auto-aprendizagem.

Passo

1

Fazer

download no link abaixo:

http://www.cloudera.com/downloads.html

Selecione o download

do QuickStarts.

Passo 2

Na próxima tela selecione a versão “QuickStarts for CDH 5.8” e escolha a

plataforma desejada (no nosso caso utilizaremos a Virtual Box).

Passo 3

Clique no botão:

Passo 4

Preencha os dados solicitados na tela abaixo e clique em "CONTINUE":

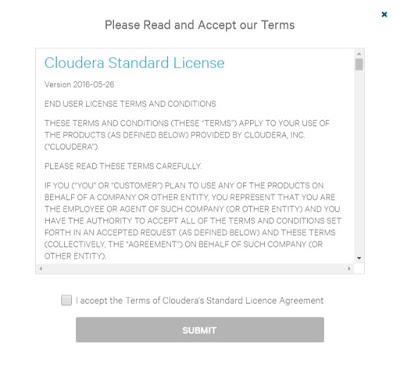

Passo 5

Leia e aceite os termos e clique em “SUBMIT”.

O download será iniciado...

Passo 6

Após termino do download faça a

descompactação do arquivo abaixo:

cloudera-quickstart-vm-5.8.0-0-virtualbox.zip

Arquivos descompactados: